Il 14 febbraio 2026 ho registrato seocodice.online. Non un .com, non un .it — un .online. Di proposito. L’obiettivo è semplice: dimostrare che con un’infrastruttura SEO perfetta, anche un TLD svantaggiato può competere con i domini premium.

Indice dei contenuti

- La Tesi: Infrastructure Batte TLD

- Perché un .online e Non un .com?

- Setup Tecnico: Da Zero a Live in 1 Ora

- 1. Registrazione e DNS

- 2. Virtual Host Apache + SSL

- 3. Landing Page: Zero JavaScript, Zero Font Esterni

- 4. Schema.org Cross-Domain: Il Pezzo Forte

- 5. robots.txt con Policy AI Selettiva

- 6. Backlink Semantico da profpaul.icu

- Cosa Misuro e Come

- Timeline e Obiettivi

- Aggiornamenti

- Aggiornamento #1 — 14 Febbraio 2026 (Giorno 0)

Questo post documenta l’esperimento in tempo reale. Aggiornerò i risultati man mano che Google indicizza e posiziona il sito.

La Tesi: Infrastructure Batte TLD

Il mondo SEO tradizionale dice che il .com è il TLD migliore per il ranking: più trust, più autorità percepita, CTR superiore nelle SERP. Ed è vero — a parità di condizioni. Google stesso ha chiarito che i fondamentali tecnici contano più del nome a dominio.

Ma cosa succede quando le condizioni non sono pari? Quando un .online ha infrastruttura perfetta e un .com ha il solito sito WordPress con plugin pesanti, schema.org generato da Yoast e PageSpeed a 60?

La mia ipotesi: l’infrastruttura tecnica pesa più del TLD. E intendo dimostrarlo con dati verificabili. Come confermato da Google nel 2015, i nuovi TLD non hanno né vantaggi né svantaggi intrinseci nel ranking.

Perché un .online e Non un .com?

Scelta deliberata. È come allenarsi con i pesi alle caviglie: se riesci a posizionare un .online, quando passi al .com il vantaggio è ancora maggiore. Il .online costa poco, il rischio finanziario è zero, e il risultato diventa una case study potentissima.

Inoltre, se l’esperimento funziona, dimostra che la mia metodologia Divergent Authority regge anche nelle condizioni più sfavorevoli.

Setup Tecnico: Da Zero a Live in 1 Ora

Ecco cosa ho fatto, passo per passo.

1. Registrazione e DNS

Dominio registrato su Hostinger. Record A puntato al mio VPS Ubuntu (stesso server di profpaul.icu). CNAME per www. TTL iniziale a 60 secondi per propagazione rapida, come consigliato nelle best practice DNS di Cloudflare.

2. Virtual Host Apache + SSL

Virtual host configurato con DocumentRoot dedicato, AllowOverride All per futuri .htaccess, e moduli di sicurezza attivi. Certificato SSL Let’s Encrypt con auto-redirect HTTP → HTTPS e www → non-www via RewriteRule 301.

Risultato: quattro varianti URL (http/https × www/non-www) convergono tutte su un’unica versione canonica: https://seocodice.online/. Questo è fondamentale per evitare problemi di contenuto duplicato secondo Google.

3. Landing Page: Zero JavaScript, Zero Font Esterni

La pagina è un singolo file HTML con CSS inline. Nessun JavaScript. Nessun font esterno (uso system-ui). Nessuna immagine. Il design è identico a profpaul.icu per coerenza brand: stesso color scheme, stesse card, stessi hover effect.

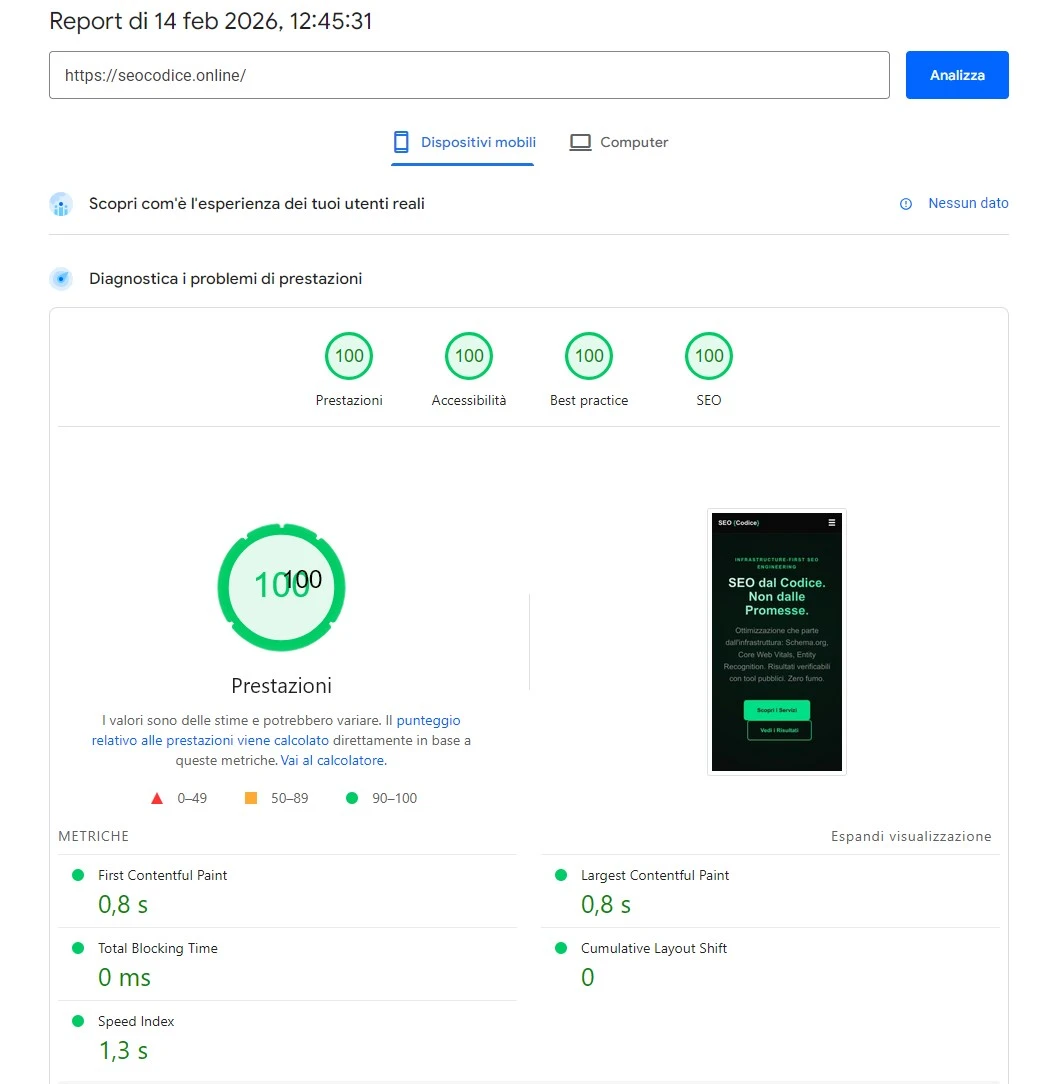

Il risultato su PageSpeed Insights:

- Prestazioni: 100

- Accessibilità: 100

- Best Practice: 100

- SEO: 100

FCP e LCP a 0.8s, Total Blocking Time a 0ms, CLS a 0. Non c’è margine di miglioramento — è il massimo ottenibile. I Core Web Vitals sono un fattore di ranking confermato da Google dal 2021.

4. Schema.org Cross-Domain: Il Pezzo Forte

Qui è dove l’infrastruttura fa la differenza vera. Lo Schema.org di seocodice.online non è un blocco isolato — è un @graph interconnesso che collega due entità su due domini diversi, seguendo le linee guida Google per i dati strutturati:

- Organization (SEO Codice) con

founder→profpaul.icu/#person - Person (Paolo Galbiati) referenziata via

@idcross-domain - Service con

provider→ Organization eOfferCatalogdettagliato - WebSite e WebPage con breadcrumb e relazioni semantiche complete

Questo dice a Google: “SEO Codice è un servizio fondato da Paolo Galbiati, la stessa persona di profpaul.icu”. L’autorità di un dominio rafforza l’altro. Non è link building — è entity engineering. Un approccio che ho documentato anche nel mio case study PageSpeed 100.

5. robots.txt con Policy AI Selettiva

Il robots.txt non è solo un file tecnico — è una strategia di accesso. Ho configurato permessi espliciti per i crawler AI che contano, seguendo le specifiche robots.txt di Google:

- Allow: Googlebot, GPTBot, Google-Extended, ChatGPT-User, Claude-Web

- Disallow: Bytespider (TikTok), CCBot (Common Crawl)

L’obiettivo è essere citato nelle AI Overview di Google e nei risultati di ChatGPT/Claude, bloccando chi scrappa senza restituire valore.

6. Backlink Semantico da profpaul.icu

Un singolo link nel footer di profpaul.icu verso seocodice.online. Non è un backlink qualsiasi — è un link coerente con lo Schema.org (founder → organization). Google vede la relazione nel markup strutturato E nel link fisico. Doppio segnale, zero manipolazione. Questo approccio è in linea con le linee guida Google sull’Helpful Content.

Cosa Misuro e Come

L’esperimento sarà monitorato con strumenti pubblici e verificabili:

- Google Search Console — impressioni, click, posizione media, pagine indicizzate

- PageSpeed Insights — Core Web Vitals (deve restare 100/100/100/100)

- Schema.org Validator — markup sempre pulito, zero errori

- Rich Results Test — verifica rich snippet eligibility

- Sistema rank tracking Python custom — posizioni SERP reali, non stimate

Niente tool proprietari. Niente report PDF. Tutto verificabile da chiunque, in qualsiasi momento.

Timeline e Obiettivi

- Giorno 0 (14 feb 2026): Sito live, indicizzazione richiesta, sitemap inviata ✅

- Settimana 1: Prima indicizzazione attesa. Verifica che Google riconosca le entità Schema.org

- Settimana 2-4: Prime impressioni in GSC. Analisi keyword per cui Google mostra il sito

- Mese 2-3: Posizionamento target. Obiettivo: prima pagina per almeno 1 keyword rilevante

- Mese 6: Valutazione finale: il .online ha competuto con i .com? Migrazione al .com se i risultati confermano la bontà del progetto

Aggiornamenti

Aggiornamento #1 — 14 Febbraio 2026 (Giorno 0)

Sito live. PageSpeed 100/100/100/100. Schema.org validato senza errori. Indicizzazione richiesta via GSC. Sitemap inviata e accettata. robots.txt con policy AI configurato. Backlink da profpaul.icu attivo.

Stato: In attesa della prima scansione Google.

Questo post verrà aggiornato regolarmente con i risultati dell’esperimento. Visita seocodice.online per verificare tu stesso le metriche in tempo reale.